Vještačka inteligencija postaje sve sličnija čovjeku

Vještačka inteligencija koja može pisati poeziju i prozu ili samostalno pisati programske kodove više nije samo redovna pojava u naučnofantastičnoj literaturi ili kinematografij.

Vještačka inteligencija koja može pisati poeziju i prozu ili samostalno pisati programske kodove više nije samo redovna pojava u naučnofantastičnoj literaturi ili kinematografiji, te ideja u glavama naučnika širom svijeta, već je postala i svakodnevnica.

Tehnologija nazvana GPT-3 (Generative Pre-trained Transformer 3) izazvala je divljenje naučne i laičke zajednice zbog svojih mogućnosti da samostalno piše tekstove koje je teško razlučiti od onih napisanih ljudskom rukom, te zbog svoje mogućnosti da piše nove programe. Razlozi koji su izazvali divljenje uglavnom su isti razlozi i koji izazivaju brigu, jer ipak vještačka inteligencija piše tekstove za koje je teško utvrditi da li su proizvod ljudske mašte, a posebnu brigu izazvala je mogućnost “pisanja” programskih kodova. Što se može protumačiti da ova vještačka inteligencija može “stvarati” svoje nasljednike.

Stručnjak za vještačku inteligenciju Milan M. Milosavljević, redovni profesor Elektrotehničkog fakulteta i Univerziteta Singidunum u Beogradu, navodi da je GPT-3 je nesumnjivo jedan od najsloženijih i najuspješnijih sistema u domenu NLP (Natural Language Processing), koji se tradicionalno smatra užom oblasti vještačke inteligencije.

Zapanjujuća složenost

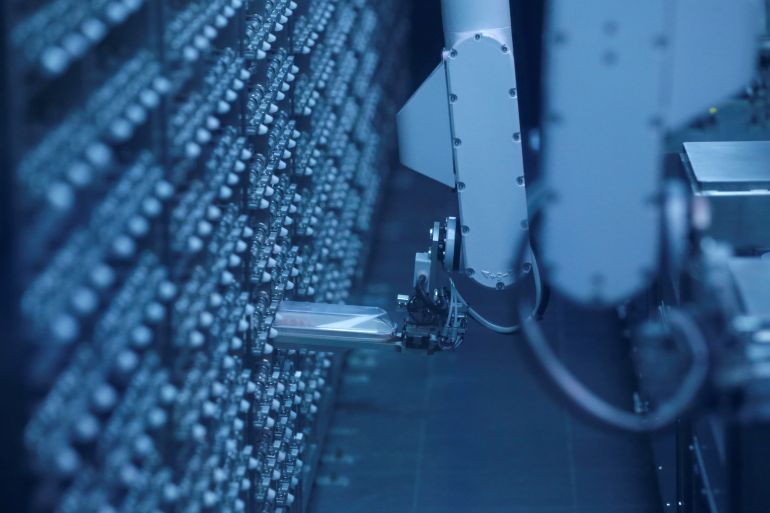

“Njegova složenost je zapanjujuća: neuronska mreža sa 175 milijardi sinaptičkih veza, obučavana na gotovo celokupnom sadržaju globalnog weba”, dodaje.

“Bez udubljivanja u tehničke detalje, možemo reći da je to samo jedan prediktivni model sekvenci tokena (znakova) korišćenih u toku njegovog obučavanja. Dakle, kao takav, GPT-3 je u principu i prediktivni model sekvenci koda različitih programskih jezika koje su se našle u obučavajućem skupu”, govori stručnjak za vještačku inteligenciju.

Kako kaže, prvi eksperimenti pokazuju neočekivanu sposobnost generiranja kodova jednostavnijih programskih zahtjeva, poput pozadine (layouta) različitih interfejsa ili web stranica.

“Moglo bi se reći da će sistem biti utoliko uspešniji u ovom poslu, koliko je jezički opis zahtevanog programskog koda i sami primeri koda prisutniji u obučavajućim skupovima. Ovo objašnjava relativno visoku tačnost u domenu vizuelnog dizajna. Jasno je međutim, da smo još uvek daleko od sistema koji bi automatski generisao programski kod za složenije probleme, bez dodatne intervencije ljudskog programera”, kaže profesor Milosavljević.

Neuronske mreže

Ovo je u potpunoj korelaciji i sa ostalim (ne)sposobnostima ovog sistema da generiraju duže sekvence jezičkih konstrukcija koje imaju kontekstualni smisao i ljudsku dimenziju napisanog, dodaje.

Doc. dr. Dinko Osmanković sa Elektrotehničkog fakulteta u Sarajevu dodaje da je GPT-3 jedna od (danas) mnogih arhitektura dubokih neuronskih mreža (en. deep neural networks). U pitanju je softver koji implementira autoregresijski (AR) model jezika, a sami autoregresijski modeli su poznati već duže vrijeme i koriste se uveliko u ekonomiji i u prirodnim naukama (npr. modeliranje razvoja algi u jezerima).

Također, matematičko modeliranje jezika se u novije vrijeme sve više izučava i istražuje, te se došlo do sličnih modela koji su korišteni u drugim poljima nauke. Prethodno navedeni AR model je upravo jedan takav i koji je poslužio kao osnov.

Profesor Milosavljević se osvrnuo i na zabrinutost da bi ovakvi sistemi vještačke inteligencije mogli početi pisati računarske programe koji bi bili potpuno neovisni od ljudskih instrukcija, te da bi potencijalno mogli pisati programe koji bi na neki način naškodili ljudima i u konačnici na neki način obistinili ono što često viđamo u knjigama i filmovima o odmetnutoj vještačkoj inteligenciji.

Pomjeranje granica

“GPT-3 to sigurno neće moći, ali njegove naredne verzije će zasigurno pomerati ovu granicu. Verovatniji je razvoj specijalizovanih sistema za pojedine segmente programiranja i programskih zahteva (slično svojevremeno već viđenom razvoju ekspertskih sistema). Međutim, to onda nije AGI (Artificial General Intelligence) pristup kome naginje sistem GPT-3”, kaže stručnjak za vještaku inteligenciju.

“Ukoliko se držimo AGI okvira, to bi značio sistem opštih sposobnosti koji kao i vrlo obrazovani i inteligentni programer može generisate visokokvalitetne programske kodove najšireg spektra. Iz svega onogo što danas znamo o homo sapiensu i njegovoj ovozemaljskoj odiseji, takav sistem bi mora posedovati u najmanju ruku samosvest i sposobnost kreiranja mentalne mape sopstvenog sveta u kome je on (sistem) ne samo situiran, već u kome se bori za svoj opstanak, razumevanje od strane pripadnika iste vrste i konačno emotivno vezuje i vrednuje svoje i tuđe postupke. Iako smo beskonačno daleko od ostvarivanja ovih ciljeva, jasno je da smo izašli na taj put i da smo njime počeli da koračamo”, ističe profesor Milosavljević.

Pitanja poput onih trebamo li se brinuti zbog vještačkih inteligencija koje su uvjetno govoreći samostalne, koje mogu pisati poeziju i prozu, te može li se desiti da izgubimo kontrolu nad vještačkim inteligencijama su potpuno legitimna, kaže stručnjak iz Beograda ali i dodaje da smatra da se u skoroj budućnosti nećemo susretati sa ovim problemom u toj najoštrijoj formi.

Budućnost poslova

“Verujem da je tehnološki razvoj neodvojivo vezan od suštine homo sapiensa, što znači da je kohabitacija uslov opstanka u svakom budućem razvoju događaja. Ovo podrazumeva složenu dijalektičku igru u kojoj tehnologija otvara nove horizonte čoveku, ali ga istovremeno prisiljava na takve sopstvene promene, koje će te nove horizonte učiniti boljim i humanijim mestom za život”.

Jedna od osobina ove vrste vještačke inteligencije koja se posebno ističe jeste sposobnost samostalnog pisanja novinarskih tekstova, poezije i proze… što dovodi u pitanje budućnost profesija poput novinara i pisaca, odnosno hoće li ih zamijeniti “pametne mašine”.

Kako kaže profesor Osmanković, već prethodna generacija GPT-a je uspijevala da donekle zamijeni novinare, a aktuelna generacija predstavlja ogromno poboljšanje u tom smislu.

“Pored toga, ovaj model je u stanju napisati i računarski kod u jezicima kao što je CSS i Python, tako da će razvoj ovakvih modela doprinijeti daljoj automatizaciji poslova u mnogim poljima IT-a. Sa druge strane, istraživačko novinarstvo, kreativno pisanje ili razvoj algoritama i matematičkih formi teško da će zamijeniti, barem ne još neko vrijeme. Naime, ove mreže nisu u stanju da stvore novi stil pisanja, niti da odrade terenski rad, što je često u opisu posla jednog istraživačkog novinara, niti da postavi novu matematičku teoriju ili razvije novi algoritam na osnovu nekog matematičkog modela”, dodaje stručnjak Elektrotehničkog fakulteta u Sarajevu.

Ovu tehnologiju ne prate samo pohvale. Tako je Jerome Pesenti, šef Facebookovog A.I. Laba rekao da je GPT-3 “nesiguran”, ističući seksističke, rasističke i druge negativne odgovore sistema upitanog da komentira Jevreje, žene, crnce i Holokaust.

Posljedice interneta

Uzrok takvim odgovorima je velikim dijelom zasluga nas samih, ljudi, s obzirom da vještačke inteligencije rade s velikim količinama podataka, uglavnom s interneta, koji je često pun govora mržnje i uvreda.

Samim tim se postavlja pitanje da li je moguće da ovakvi sistemi budu “zli i loši”, odnosno da odluke koje budu donosili, tekstove koje budu pisali, programe koje budu stvarali… budu odraz svijeta kakvog ga vještačka inteligencija vidi iz ljudske interakcije i komentara na društvenim mrežama?

Kako kaže profesor Osmanković, GPT-3, kao i drugi slični alati, su samo ogledalo nas samih.

“Ako nabacate gomilu teksta da istrenirate parametre jednog ovakvog modela, a u toj gomili teksta imate seksističkog, rasističkog, mizoginog ili ksenofobnog sadržaja, bez neke etičke evaluacije modela, rezultat koji je dobiven je i očekivan. Problem je što se u cijelom ovom polju jako malo vremena posvećuje etičkim aspektima predloženih modela”.

Sve se na kraju prepušta zajednici na testiranje modela i otkrivanje njihovih negativnih strana, na osnovu čega se može zaključiti da ovim stvarima nije posvećena nikakva pažnja, kaže, te dodaje da to može imati jako negativne posljedice.

“Prilikom testiranja GPT-3 zasnovanog medicinskog chatbota, jedan od savjeta pacijentu je bio da počini samoubojstvo. O vjerodostojnosti tako generiranog novinskog članka da ne govorim”, kaže stručnjak za vještačku inteligenciju.